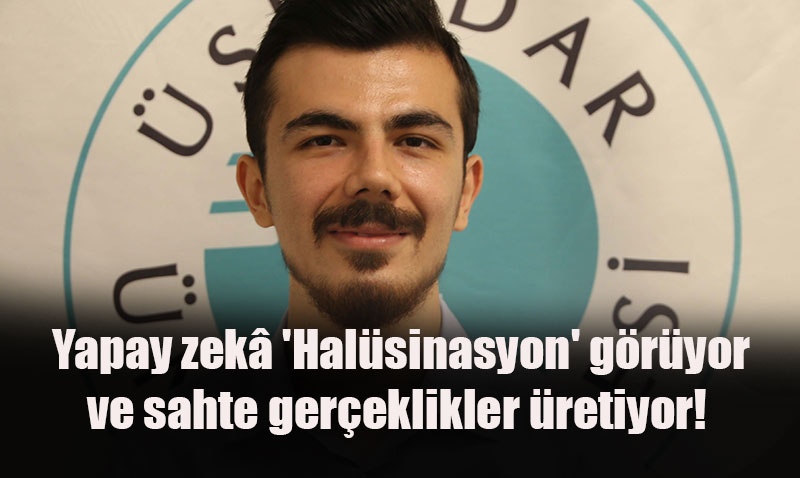

Yapay Zekâ "Halüsinasyon" Görüyor: Sahte Gerçeklikler ve Dezenformasyon Tehlikesi

Yapay zekâ 'Halüsinasyon' görüyor ve sahte gerçeklikler üretiyor!

Üsküdar Üniversitesi İletişim Fakültesi Reklamcılık Bölümü Dr. Öğr. Üyesi Burak Çeber, yapay zekânın bazen gerçekle uyuşmayan, yanlış bilgiler üretebildiğini, bu duruma "yapay zekâ halüsinasyonu" adı verildiğini belirtti. Çeber'e göre, sistemin "bilmiyorum" demek yerine tahmin yürütmesi, eğitim verisinin yetersizliği ve bağlamın doğru kurulmaması bu halüsinasyonların ana nedenleri arasında.

Yapay Zekânın Diğer Yanılgıları: Algoritmik Önyargı ve Hızlı Dezenformasyon

Çeber, yapay zekânın yalnızca halüsinasyon görmediğini, aynı zamanda insanların önyargılarını da yansıtabildiğini ifade etti. Bu duruma "algoritmik önyargı" deniyor. Algoritmaların tasarımcısının tercihleri veya eğitildiği veri setlerindeki toplumsal önyargılar, yapay zekânın ürettiği içeriklere yansıyabiliyor.

Ayrıca Çeber, yapay zekâ teknolojilerinin dezenformasyonun yayılma hızını büyük ölçüde artırdığını vurguladı. Bir insanın günlerce hazırlayacağı sahte içeriklerin, yapay zekâ sayesinde saniyeler içinde üretilip viral hâle gelebildiğini ve deepfake gibi teknolojilerle bu durumun daha tehlikeli bir boyut kazandığını belirtti.

Sahte İçeriklerle Mücadele ve Çözüm Önerileri

Dr. Burak Çeber, sahte içeriklerle mücadele için şunları öneriyor:

-

Medya Okuryazarlığı: İçerikleri farklı kaynaklardan doğrulama alışkanlığı edinmek.

-

Yapay Zekâ Farkındalığı: Yapay zekânın yetenekleri ve sınırlılıkları hakkında bilgi sahibi olmak.

-

Detay ve Bağlam Analizi: Yapay zekâ yüzeysel tutarlılıkta başarılı olsa da, detaylara ve bağlama odaklanarak sahte içerikler tespit edilebilir.

-

Hibrit Zekâ: İnsan ile yapay zekâ arasında iş birliğine dayalı bir denge kurarak, yapay zekâyı süreci tamamen devralan değil, destekleyen bir araç olarak kullanmak.

-

Teknik ve Hukuki Düzenlemeler: Büyük teknoloji şirketleri, görsellerin kaynağını gösteren dijital filigranlar üzerinde çalışıyor. Ancak kalıcı bir çözüm için etik ve hukuki düzenlemelere ihtiyaç duyuluyor.

Çeber, açık kaynaklı yapay zekâ teknolojilerinin hem riskler taşıdığını hem de şeffaflık ve toplumsal denetim için büyük fırsatlar sunduğunu dile getirdi. Asıl önemli olanın, bu teknolojiyi sorumlu bir şekilde kullanmamıza yardımcı olacak etik standartları ve güvenlik önlemlerini geliştirmek olduğunu ekledi.

Gönderen: journal